Computerevolution

Vom Gedankenkonstrukt zum Quantenkonstrukt

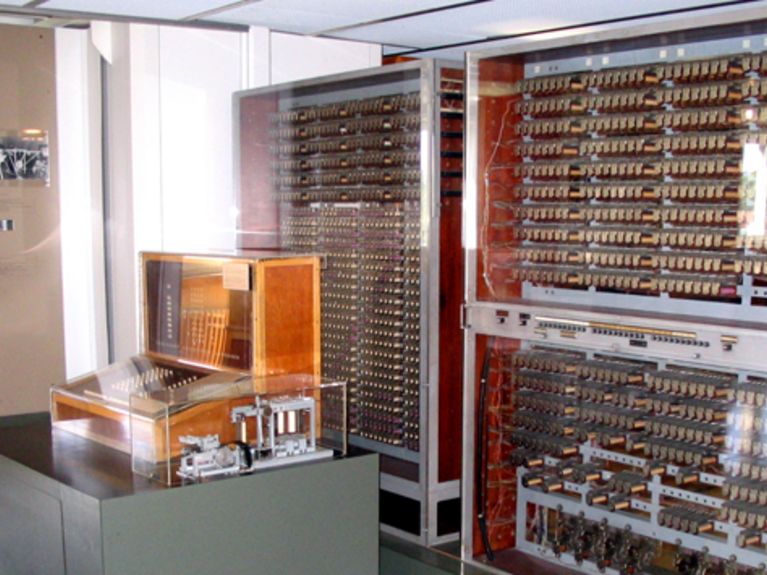

Der Z3 im Deutschen Museum in München. CC-BY-SA-3.0

Vor 75 Jahren präsentierte Konrad Zuse den Z3. Die ersten frei programmierbaren Rechenmaschinen waren so groß wie eine Schrankwand und jedem heutigen Taschenrechner unterlegen. Eine kleine Historie des Computers und ein Blick in die Zukunft anlässlich des Jubiläums.

Heute sind Computer winzig klein und enorm leistungsfähig. Ein vollwertiger Rechner belegt kaum mehr Fläche als ein Ein-Euro-Stück . Als die Geschichte des modernen Computers begann, war man schon froh, wenn der Rechner in ein Zimmer passte. Das war am 12. Mai 1941, mitten im zweiten Weltkrieg. Damals stellte der deutsche Ingenieur und Erfinder Konrad Zuse seine „Z3“ vor. Die Maschine gilt als der erste funktionsfähige, frei programmierbare Computer der Welt und das Kriegsjahr 1941 damit als die Geburtsstunde des modernen Computers. Doch bevor der Computer von Zimmergröße auf Maße eines Euros schrumpfen konnte, musste er erst einmal riesengroß werden.

Die Trennung von Maschine und Programm

Der erste Programmierer war eine Frau. Ada Lovelace. CC-BY-SA-3.0

Lässt man einmal die Vordenker mit ihren Leistungen bei der Entwicklung von Rechenmaschinen ein wenig beiseite, landet man in den Jahren um 1830 bei Charles Babbage und Ada Lovelace. Beide gelten laut Jürgen Becker, Leiter des Instituts für Technik der Informationsverarbeitung am Karlsruher Institut für Technologie, als Pioniere der Geschichte des Computers. Babbage, ein wohlhabender Mathematiker und Erfinder, entwickelte im Laufe seines Lebens mit der „Analytical Engine“ eine mechanische Rechenmaschine, die bereits programmierbar gewesen wäre, hätte sie Babbage bis zu seinem Tod tatsächlich fertigstellen können. Sie gilt als Vorläufer des modernen Computers.

Auch Ada Lovelace entstammt einem guten Haus, was ihr eine naturwissenschaftliche Ausbildung ermöglichte und zu dieser Zeit keine Selbstverständlichkeit war. Während ihrer jungen Jahre lernte sie Babbage kennen. Später übersetzte sie eine Beschreibung der Analytical Engine ins Englische und fügte eigene visionäre Gedanken hinzu: So hat Lovelace unter anderem formuliert, dass eine Rechenmaschine mehr könne, als nur mathematische Aufgaben zu lösen. Zudem postulierte sie die Trennung von Maschine und Programmierung, ein Prinzip, das wir heute als die Unterteilung in Hard- und Software kennen. Nicht zuletzt gilt Ada Lovelace als erster Programmierer der Welt. Sie hatte für die Maschine von Babbage einen Berechnungsablauf geschrieben, der als erstes formales Programm gilt.

Groß und immer größer

Nachbau der Z1. CC-BY-SA 3.0

Weiterentwicklung mit Gesetzeskraft

Xerox Alto. CC-BY-SA 3.0

Die Entwicklung der Halbleitertechnik und deren Leistungszuwachs interessierten den noch jungen Wissenschaftler Gordon Moore. Er beobachtete die Neuerungen mit großem Interesse. Besonderes Augenmerk legte er auf die Zahl der integrierten Transistoren. Er stellte fest, dass sich deren Zahl alle ein bis zwei Jahre verdoppelte. In einem Aufsatz im Jahr 1965 formulierte er seine Beobachtungen. Damit war das „Moorsche Gesetz“ formuliert. Mit Einschränkungen gilt es bis heute und beschreibt den regelmäßigen Leistungszuwachs bei Prozessoren.

Zurück zur beginnenden Miniaturisierung: Mit ihr nahm die Computerindustrie Fahrt auf und der Weg war frei, für jene Entwicklungen, die dem heutigen Personal Computer schon ziemlich ähnlich waren. Den Anfang in dieser Richtung machte der Xerox Alto.

Der erste Mac. CC-BY-SA-3

Noch ferne Zukunft

Leser:innenkommentare