Aufstieg der Roboter

Bislang sind die meisten Roboter nur dumpfe, unermüdliche Helfer: In Fabriken führen sie tausendfach die immer gleiche Bewegung aus, im Garten drehen sie ihre Runden und mähen den Rasen. Doch dank der Fortschritte in der künstlichen Intelligenz könnten sie bald zum selbstständigen, cleveren Kameraden in allen Lebenslagen avancieren.

Automaten faszinieren den Menschen seit vielen Hundert Jahren. Schon in der Antike öffneten sie mit einer ausgeklügelten Mechanik Tempeltüren, spielten Musik oder füllten Trinkgefäße. Im ausgehenden Mittelalter beschrieb Leonardo da Vinci sogenannte menschenähnliche Androiden. Und seit Jules Verne sind Roboter aus der Science-Fiction-Literatur nicht mehr wegzudenken, auch wenn sie diese Bezeichnung streng genommen erst 1920 erhalten haben. Der tschechische Schriftsteller Josef Čapek wählte damals den Begriff, der sich mit „Frondienst“ übersetzen lässt. Heute bauen Roboter im Auftrag ihrer Gebieter Autos, erkunden den Mars und sind als Spielzeuge für Groß und Klein sogar in Wohnzimmern weit verbreitet.

Der Astronautenroboter CIMON begleitet Alexander Gerst an Bord der ISS. Bild: Airbus

Antike Tempeltüröffner und moderne Schweißroboter haben eines gemein: Stur führen sie Befehle aus, die ihnen ihre Erbauer in komplizierten Mechaniken oder unzähligen Zeilen Quellcode hinterlegt haben. An allem, was darüber hinausgeht, scheitern sie: Autonom agieren, sich auf unbekanntem Terrain zurechtfinden, mit neuen Werkzeugen hantieren – das können Roboter nicht. Noch nicht: Denn der rasante Fortschritt auf dem Gebiet der künstlichen Intelligenz (KI) könnte Roboter vom reinen Werkzeug zum smarten Partner für den Menschen aufsteigen lassen. Ein Beispiel dafür ist derzeit 400 Kilometer über der Erde im Einsatz: Der Roboter CIMON schwebt seit Juni 2018 zusammen mit dem Astronauten Alexander Gerst durch die Internationale Raumstation ISS. CIMON ist kreisrund, misst 32 Zentimeter und ist noch in der Ausbildung. „Er ist der allererste Schritt auf dem Weg zu einem autonomen, KI-gesteuerten Assistenzsystem für Weltraummissionen“, erzählt Volker Schmid vom Raumfahrtmanagement des Deutschen Zentrums für Luft- und Raumfahrt (DLR). „An Bord der ISS testen wir erst einmal die grundlegenden Funktionen wie Sprachsteuerung, Gesichtserkennung, Manövrierfähigkeit und Navigation, aber auch die Akzeptanz durch die Astronauten."

Mit Kameras, Mikrofonen und Ultraschallsensoren ausgestattet, kann CIMON sehen, hören und Objekte erkennen. Ventilatoren erlauben ihm, sich in der Schwerelosigkeit zu bewegen. Mit Schwenkbewegung von oben nach unten nickt er, auch den Kopf schütteln kann er. Wird er angesprochen, wendet er dem Astronauten das Gesicht zu. Auf Fragen antwortet er über seinen Lautsprecher oder zeigt Bilder und Texte auf dem Display an, wo eben noch sein Smiley-Gesicht gewesen ist. Für diesen Einsatz musste CIMON auf der Erde lange üben: Über Mikrofone hat sich Astronaut Alexander Gerst mit seinem künftigen Assistenten unterhalten und so dessen künstliches neuronales Netz mit seinen Stimm-Mustern und Sprechgewohnheiten trainiert. Dieser Aufwand zahlt sich zumindest mittelfristig aus, hofft Volker Schmid: „In den kommenden drei bis acht Jahren wollen wir CIMON zu einem volloperationellen System weiterentwickeln. Er soll sich autonom in einer Raumfahrtumgebung bewegen und die Astronauten bei ihren Tätigkeiten unterstützen.“ Das Kalkül dabei: Wenn ein Roboter den Astronauten zeitraubende Routineaufgaben abnimmt, können die sich viel intensiver den wissenschaftlichen Experimenten an Bord widmen.

„Wir wollen den Pfleger nicht ersetzen, wir wollen ihn unterstützten [...], damit er mehr Zeit für den Pflegebedürftigen hat.“

Ähnlich hochgesteckt sind die Ziele, die sich Forscher im bayerischen Oberpfaffenhofen gesteckt haben: „Wir arbeiten an Robotern, die in Zukunft dabei helfen könnten, die Autonomie von beeinträchtigten Menschen in ihrer gewohnten Umgebung so lange wie möglich zu erhalten“, sagt Annette Hagengruber. Die Ingenieurin ist Teil des SMiLE-Teams am DLR-Institut für Robotik und Mechatronik. Herz des Projekts sind zwei Systeme, denen ein futuristischer Name gemein ist: „Rollin’ Justin“ heißt das eine Konzept, EDAN das andere. „Wir wollen in erster Linie herausfinden, wo die Robotik in Pflegeheimen unterstützen kann“, erzählt Hagengruber, die zur EDAN-Forschergruppe gehört. „Wir wollen den Pfleger nicht ersetzen, wir wollen ihn unterstützten und ihm manche Aufgaben vereinfachen, damit er mehr Zeit für den Pflegebedürftigen hat.“

Der Pflegeroboter EDAN kann aus Muskelsignalen und unterstützt von künstlicher Intelligenz schließen, was von ihm gefordert wird. Bild: Sven Hoppe/dpa

EDAN – eine Kombination aus Rollstuhl, beweglichem Roboterarm und Hand – hat bereits Erfahrungen in der Pflege von Menschen mit motorischen Einschränkungen sammeln können. Restmuskelsignale im Arm des Patienten steuern es. Künstliche Intelligenz lässt EDAN dabei vorausschauend handeln, denn dank gesammelter Daten kann er vorhersehen, was sein Schützling als Nächstes tun möchte. Auch „Rollin’ Justin“ hat sich bereits in der Praxis bewährt – er ist ein humanoider Roboter, der stattliche 1,91 Meter misst. Doch wie integrieren sich die zwei Roboter in den laufenden Betrieb eines Pflegeheims und welche Aufgaben übernehmen sie dort? „Das wollen wir nicht aus unserer Ingenieurssicht entscheiden“, sagt Annette Hagengruber. „Deshalb arbeiten wir eng mit der Caritas in Garmisch-Partenkirchen zusammen. Justin und EDAN werden dort ab Ende 2018 eingesetzt.“ Die Vision: In Pflegeheimen könnten sie Routineaufgaben übernehmen. Und bei den Patienten zu Hause wären sie dafür zuständig, im Haushalt zu helfen, Brille oder Wasser-glas zu bringen und im Notfall eigenständig einen Arzt zu rufen.

Menschen in häuslicher Umgebung unterstützen, können auch die Roboter, die Tamim Asfour mit seinem Team entwickelt. Der Professor leitet den Lehrstuhl für Hochperformante Humanoide Technologien am Institut für Anthropomatik und Robotik am Karlsruher Institut für Technologie (KIT) und begann während seiner Dissertation im Jahr 1999 mit der Entwicklung. Mittlerweile gibt es sechs Generationen seines Roboters, den er ARMAR genannt hat; die ersten Roboter sind für den Haushalt konzipiert. Jetzt geht Tamim Asfour den nächsten Schritt: „ARMAR-6 wurde im Rahmen des europäischen SecondHands Project entwickelt und soll Techniker bei Wartungsaufgaben in industriellen Anlagen unterstützen.“

Dabei feilen die Wissenschaftler in Karlsruhe nicht nur an den mechanischen Fähigkeiten ihres Schützlings. Eine zentrale Rolle spielt die Frage, wie ihre Roboter neue Fähigkeiten erlernen können. „Uns ist wichtig, dass sie später keinen Experten brauchen, der ihnen neue Dinge beibringt. Stattdessen sollen sie lernen, indem sie Menschen bei ihren Tätigkeiten beobachten. Wir nennen das Imitation Learning oder Lernen durch Vormachen. Der Roboter beobachtet, generiert daraus eigene Fertigkeiten, führt sie aus, prüft sein Vorgehen mit den bisher gesammelten Erfahrungen und wird sein Verhalten beim nächsten Mal entsprechend anpassen.“ Derzeit soll sich ARMAR-6 im Lagerhaus eines britischen Online-Supermarktes bewähren. Dort soll er seinem menschlichen Servicetechniker nicht nur passendes Werkzeug reichen, sondern auch erkennen, wann dieser eine helfende Hand benötigt.

Am KIT arbeitet Torsten Kröger am Institut für Anthropomatik und Robotik. Zuvor war er als Bereichsleiter für Robotersoftware bei Google tätig. Bild: KIT

Das erste Mal taucht der Begriff „künstliche Intelligenz“ 1955 in einem Projektantrag auf. Die daraus resultierende Darthmouth Conference ein Jahr später markiert seither die Stunde null der eigenständigen KI-Forschung. Beinahe euphorisch wurde ein rasanter Fortschritt prophezeit. Tatsächlich stellten sich schnell erste Erfolge ein. Regelbasierte Expertensysteme konnten medizinische Dialoge simulieren und bei Diagnosen unterstützen, auch die aus den 1940er-Jahren stammende Idee von künstlichen neuronalen Netzen geriet ins Visier der Forscher. Doch die Sternstunde ließ noch auf sich warten.

„Wenn es jedoch darum geht, dass Roboter physisch mit der Welt interagieren, da machen wir gerade die allerersten Schritte.“

„Die größten Durchbrüche auf dem Gebiet des maschinellen Lernens haben wir erst in den vergangenen Jahren erreicht“, sagt Torsten Kröger. „Und fast wöchentlich kommen neue hinzu.“ So könnten Computer Objekte auf Bildern inzwischen besser erkennen als der Mensch. „Bei der aktuellen Entwicklung müssen wir aber zwischen zwei grundlegenden Fähigkeiten unterscheiden: der Perzeption – also der visuellen Bild- oder Spracherkennung – und der Aktuation, also dem aktiven Eingreifen in die physische Welt.“ Für den ersten Bereich, die Perzeption, haben schnelle Computer, günstige Speicher und vor allem riesige, teils frei verfügbare Datenmengen das maschinelle Lernen zum Mittel der Wahl gemacht. „Das Internet ist voll von Texten, Bildern oder Videos, die wir zum Training neuronaler Netze nutzen können.“ Vor allem dieser Datenfülle verdanken perzeptive KI-Systeme ihre hohe Leistungsfähigkeit. „Wir machen jedoch gerade erst die allerersten Schritte, wenn es darum geht, dass Roboter physisch mit der Welt interagieren“, sagt Kröger. Die Herausforderung sei weniger, einen einzelnen Roboter auf eine Laborumgebung zu trainieren, sondern ein System stabil und sicher in Alltagssituationen zu integrieren.

Dass sich die Welt auf große Fortschritte einstellen darf, da ist er sich mit den meisten seiner Kollegen einig. Tamim Asfour, der Roboterentwickler aus Karlsruhe, ist sich sicher: Seine Roboter werden in naher Zukunft nicht nur Hand in Hand mit Servicetechnikern ihren Dienst tun, sondern auch im Haushalt helfen. Seine Vision: „Ich würde gern einen Roboteranzug, ein sogenanntes Exoskelett, bauen, das mir etwas beibringt“, verrät Asfour. „Stellen Sie sich vor, ich will Tango tanzen lernen. Dann würde sich eine KI die Fertigkeit beim besten Tangotänzer der Welt abschauen und auf das Exoskelett übertragen. Dieses führt dann meine Bewegungen, bis ich selbst perfekt tanzen kann.“ Das wäre der nächste große Schritt: Der Roboter wäre dann nicht mehr bloß Werkzeug oder gar Arbeitskollege, sondern sogar Lehrer.

Zum Weiterlesen:

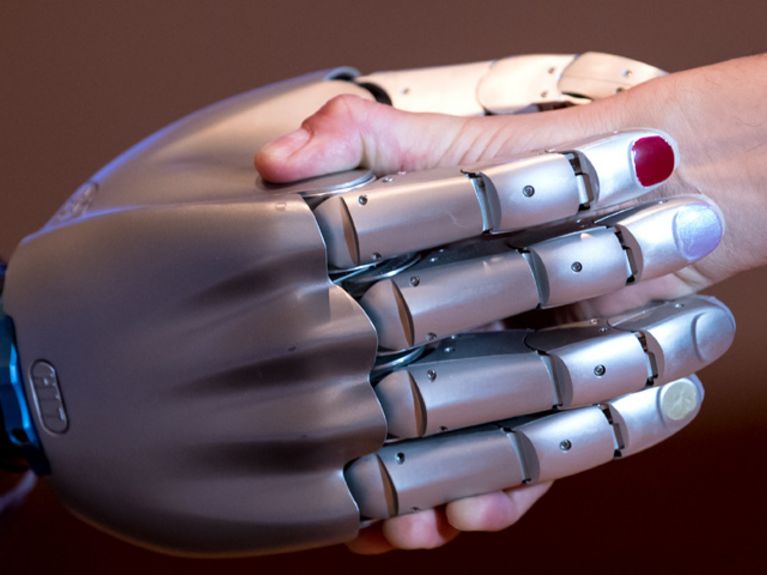

"Sensortechnik mit Fingerspitzengefühl" - Zwei Brüder aus München bringen Maschinen das Fühlen bei

Zukunftspreis für Roboter-Forscher - Die Firma Emika entwickelt flexible und kostengünstige Roboter

Leser:innenkommentare