Mit KI die biologische Kohlenstoffpumpe vermessen

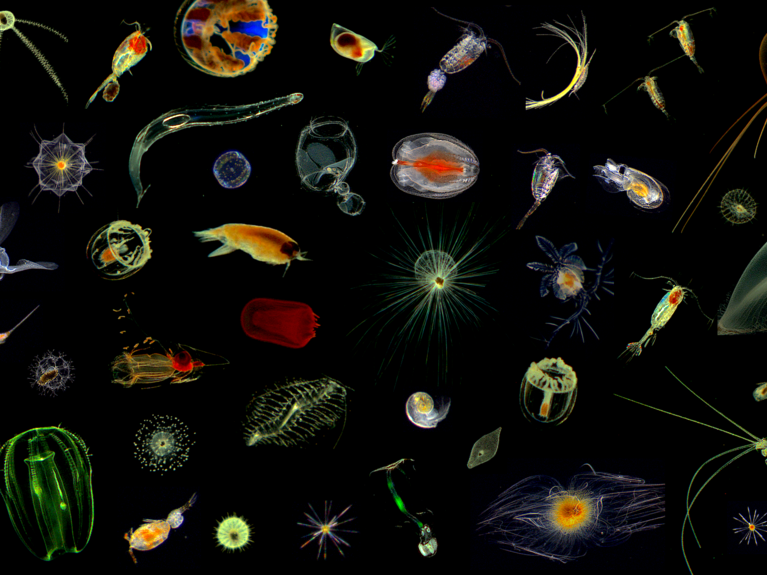

Mikrokosmos im Ozean: Bilder von Plankton, aufgenommen mit einer Unterwasser-Kamera im Nordatlantik. Bild: Hereon/Klas Ove Möller © Image: Klas Ove Möller, HEREON

Winzige Planktonorganismen verfrachten unentwegt Kohlenstoff in die Tiefsee und stabilisieren damit das Erdklima. Mit dem Projekt AqQua wollen Helmholtz-Forschende nun ein KI-System schaffen, mit dem man die Biodiversität des Planktons sowie seinen Einfluss auf das Klima global überwachen kann.

Sie sind zwar winzig, aber sie sind Viele: Einzellige Mikroalgen in den Ozeanen bestimmen durch ihre schiere Menge die Lebensbedingungen auf der Erde entscheidend mit. Genau wie Landpflanzen betreiben sie Photosynthese, bauen also mithilfe von Sonnenlicht und Kohlendioxid Biomasse auf. Als Abfallprodukt wird dabei Sauerstoff frei. Mindestens jedes zweite Sauerstoffmolekül, das durch Photosynthese entsteht, stammt aus der Produktion dieses pflanzlichen Planktons (Phytoplankton). Zudem bilden die Winzlinge die Grundlage der marinen Nahrungskette. Gefressen werden sie von kleinen Tieren (Zooplankton), die dann im Magen von Fischen landen, die wiederum zur Beute von Haien, Robben, Walen und uns Menschen werden. Ohne Mikroalgen bliebe also auch der Teller im Fischrestaurant leer.

Doch ihre vielleicht wichtigste Funktion betrifft das Klima. Das Kohlendioxid (CO2), das die Minipflanzen in der lichtdurchfluteten Oberflächenschicht des Ozeans binden, stammt größtenteils aus der Atmosphäre. Stirbt das Phytoplankton ab, wird es zu einem Großteil mikrobiell abgebaut und das CO2 wird wieder frei. Ein Teil verklumpt aber mit tierischen Ausscheidungen und anderen Partikeln zu zentimetergroßen Aggregaten, die dann in die Tiefe des Ozeans herabsinken. Jede Flocke dieses kontinuierlich fallenden „Meeresschnees“ nimmt dabei eine kleine Portion atmosphärischen Kohlendioxids mit in die Tiefsee. „Ein Teil dieser Flocken wird im Meeressediment dauerhaft eingelagert“, sagt Dagmar Kainmüller. „Jährlich werden so mehr als sechs Gigatonnen Kohlenstoff für viele hundert Jahre aus der Atmosphäre entfernt. Das entspricht etwa der gleichen Größenordnung, die pro Jahr weltweit durch die Verbrennung fossiler Energieträger frei wird. Würde es diese biologische Kohlenstoffpumpe nicht geben, wäre der CO2-Gehalt der Atmosphäre deutlich höher – und das Klima noch deutlich wärmer.“

Dagmar Kainmüller ist promovierte Informatikerin, Professorin am Potsdamer Hasso-Plattner-Institut und Leiterin der Arbeitsgruppe „Integrative Imaging Data Sciences“ am Max-Delbrück-Centrum für Molekulare Medizin in der Helmholtz-Gemeinschaft. Gemeinsam mit den Meeresforschern und Plankton-Spezialisten Rainer Kiko (GEOMAR Helmholtz-Zentrum für Ozeanforschung Kiel) und Klas Ove Möller (Helmholtz-Zentrum Hereon Geesthacht) sowie dem Big-Data-Experten Timo Dickscheid (Forschungszentrum Jülich) leitet sie das Forschungsprojekt AqQua („The Aquatic Life Foundation Project: Quantifying Life at Scale in a Changing World“). „Die Größenordnung der biologisch gepumpten Kohlenstoffmenge ist bekannt, die genaue Zahl jedoch nicht“, erklärt Dagmar Kainmüller. „Es gibt auch kein flächendeckendes globales Monitoring. Wieviel pflanzliches und tierisches Plankton gibt es überhaupt? Aus welchen Arten setzt es sich in welchen Ozeanregionen zusammen? Und wie stark schwächelt die Pumpe in Folge der globalen Erwärmung? Mit AqQua wollen wir die Antworten finden.“

Dagmar Kainmüller. Bild: Pablo Castagnola/MDC

Datenbasis für AqQua sind Milliarden von Planktonbildern, die Forschende auf der ganzen Welt mit unterschiedlichsten Mitteln generiert haben. Dazu zählen klassische Scanner, in die Meerwasserproben eingefüllt werden, fest vertäute Unterwasserkameras und mobile Unterwasserfahrzeuge, die Bilder des Planktons im umgebenden Wasser anfertigen, und viele weitere mehr. Tagtäglich kommen Millionen Fotos hinzu. Im Prinzip lässt sich so das Plankton global bis hinab in die Tiefsee überwachen. Im Prinzip. Denn nur ein kleinerer Teil der Fotos ist dabei „gelabelt“, wurde also von einem Menschen kontrolliert und mit Informationen über die zu erkennenden Planktonarten versehen. „Die große Herausforderung ist es, diese Unmenge von Bildern vergleichbar zu machen und automatisch zu kategorisieren“, sagt Dagmar Kainmüller. „Diese Aufgabe ist dabei geradezu prädestiniert für ein Foundation Model.“

Sogenannte Foundation Models revolutionieren derzeit die Wissenschaft. Durch den Einsatz künstlicher Intelligenz können sie gigantische Datenmengen verarbeiten, miteinander verknüpfen und Zusammenhänge oder Muster erkennen. Im Rahmen der Helmholtz Foundation Model Initiative (HFMI) fördert die Helmholtz-Gemeinschaft mehrere Projekte auf dem Gebiet, darunter auch AqQua. „Helmholtz ist dabei die perfekte Adresse für unser Projekt“, erklärt die Informatikerin. „In den Zentren findet sich genau die Expertise, die wir brauchen: Meeresforschung, bildgebende Verfahren, Big Data, künstliche Intelligenz und natürlich die notwendige Rechenpower.“ Getragen wird AqQua von sechs Helmholtz-Zentren (Max-Delbrück-Center, GEOMAR, Helmholtz-Zentrum Hereon, FZ Jülich, AWI & UFZ) und den beiden zentrenübergreifenden Data Science Plattformen Helmholtz Imaging und Helmholtz AI. Rund 40 renommierte Institutionen unterstützen das Projekt weltweit. „Der breite internationale Support zeigt, wie dringend die Wissenschaft auf eine Lösung wartet“, sagt die Forscherin.

Im ersten Schritt des Projekts stellen die Forschenden rund drei Milliarden Bilder aus verschiedensten Ozeanregionen zusammen. Diese stammen von vier Helmholtz-Zentren und den internationalen Unterstützern. Gut zwei Milliarden Aufnahmen sind so bereits gesammelt worden. Das Foundation Model wird dann darauf trainiert, einzelne Planktonarten korrekt zu identifizieren, ihren Zustand (also etwa Größe und Entwicklungsstadium) zu bestimmen und den Kohlenstoffgehalt abzuleiten. Das selbstlernende System wird durch das Training immer besser. „Sobald das Modell sicher arbeitet, werden wir es als einfach zu nutzendes Online-Tool öffentlich zugänglich machen und durch unseren Open-Source-Ansatz mit der weltweiten Community teilen und gemeinsam stetig verbessern“, erklärt Dagmar Kainmüller. „Um den Fluss des Kohlenstoffs und die Pumpleistung in die Tiefsee so genau wie möglich kartieren zu können, wollen wir die Bilddaten auch mit Satellitendaten koppeln.“

Erdbeobachtungssysteme wie der NASA-Satellit PACE (Plankton, Aerosol, Cloud, ocean Ecosystem) liefern zeitlich hochaufgelöste Bilder der Ozeane, von denen sich auch die Phytoplanktonkonzentration nahe der Wasseroberfläche ableiten lassen. Allerdings reichen die Daten weder in die Tiefe, noch enthalten sie Informationen zur genauen Artzusammensetzung. „Mithilfe unseres Foundation Models und den Bildanalysen aus verschiedensten Tiefen und Ozeanregionen können wir die Oberflächendaten dreidimensional in die Tiefe extrapolieren“, sagt die Informatikern. „Wir können dann regionale und globale Aussagen zur biologischen Kohlenstoffpumpe sowie zu Veränderungen in Pumpleistung, Artenzusammensetzung, Zustand und Biomasse des Phytoplanktons machen. Damit schaffen wir die Voraussetzung für noch genauere Klimamodelle, ein globales Monitoring des Phytoplanktons im Ozean und darauf basierende politische Entscheidungen.“

Link zur Projektwebsite: www.aqqua.life

Was sind Foundation Models?

Foundation Models sind Modelle für maschinelles Lernen, die mit einem sehr umfangreichen Datensatz vortrainiert werden. Durch dieses Pre-Training sind sie in der Lage, komplexe Zusammenhänge auf der Grundlage der erlernten Muster zu verstehen und zu generieren. Das aus dem anfänglichen breiten Training gewonnene Wissen kann auf viele nachgelagerte Aufgaben übertragen werden, wobei oft nur eine kleine Menge aufgabenspezifischer Daten für eine effektive Leistung erforderlich ist. Das unterscheidet Foundation Models von herkömmlichen KI-Modellen, die für eine ganz bestimmte Aufgabe trainiert werden. Foundation Models sind heute im Zusammenhang mit der Verarbeitung natürlicher Sprache bekannt (Chat-GPT), sind aber nicht auf Sprachanwendungen beschränkt. Das Konzept eines Foundation Models kann auf jeden Bereich ausgedehnt werden, in dem ein umfangreiches Modell auf einem breiten Datensatz vortrainiert und dann für bestimmte Aufgaben feinabgestimmt wird. Das macht sie auch für die Forschung so interessant.

Leser:innenkommentare